林子雨编著《大数据基础编程、实验和案例教程》(教材官网)教材中的代码,在纸质教材中的印刷效果不是很好,可能会影响读者对代码的理解,为了方便读者正确理解代码或者直接拷贝代码用于上机实验,这里提供全书配套的所有代码。

查看教材所有章节的代码

继续阅读

林子雨编著《大数据基础编程、实验和案例教程》教材第5章的代码

林子雨编著《大数据基础编程、实验和案例教程》(教材官网)教材中的代码,在纸质教材中的印刷效果不是很好,可能会影响读者对代码的理解,为了方便读者正确理解代码或者直接拷贝代码用于上机实验,这里提供全书配套的所有代码。

查看教材所有章节的代码

继续阅读

林子雨编著《大数据基础编程、实验和案例教程》教材第4章的代码

林子雨编著《大数据基础编程、实验和案例教程》(教材官网)教材中的代码,在纸质教材中的印刷效果不是很好,可能会影响读者对代码的理解,为了方便读者正确理解代码或者直接拷贝代码用于上机实验,这里提供全书配套的所有代码。

查看教材所有章节的代码

继续阅读

林子雨编著《大数据基础编程、实验和案例教程》教材第3章的代码

林子雨编著《大数据基础编程、实验和案例教程》(教材官网)教材中的代码,在纸质教材中的印刷效果不是很好,可能会影响读者对代码的理解,为了方便读者正确理解代码或者直接拷贝代码用于上机实验,这里提供全书配套的所有代码。

查看教材所有章节的代码

继续阅读

教材代码-林子雨编著《大数据基础编程、实验和案例教程》教材所有章节代码

林子雨编著《大数据基础编程、实验和案例教程》(教材官网)教材中的代码,在纸质教材中的印刷效果不是很好,可能会影响读者对代码的理解,为了方便读者正确理解代码或者直接拷贝代码用于上机实验,这里提供全书配套的所有代码。

继续阅读

林子雨编著《大数据基础编程、实验和案例教程》教材第2章的代码

林子雨编著《大数据基础编程、实验和案例教程》(教材官网)教材中的代码,在纸质教材中的印刷效果不是很好,可能会影响读者对代码的理解,为了方便读者正确理解代码或者直接拷贝代码用于上机实验,这里提供全书配套的所有代码。

查看教材所有章节的代码

继续阅读

Spark大数据分析案例之平均心率检测

案例介绍

平均心率检测案例。本案例以实验室之前发布的另一篇博客文章《Spark+Kafka构建实时分析Dashboard案例介绍》为基础,涉及模拟数据生成,数据预处理、消息队列发送和接收消息、数据实时处理、数据实时推送和实时展示等数据处理全流程,所涉及的各种典型操作涵盖Linux、Spark、Kafka、JAVA、MySQL、Ajax、Html、Css、Js、Maven等系统和软件的安装和使用方法。通过本案例,将有助于综合运用大数据课程知识以及各种工具软件,实现数据全流程操作。同时在此感谢张少坤、吴维奇和喻小丽等三位同学在创作本案例中的贡献。

继续阅读

Spark大数据之基本数据处理

Spark+Kafka构建实时分析Dashboard案例——步骤四:结果展示

返回本案例首页

查看前一步骤操作:步骤三:Spark Streaming实时处理数据

《Spark+Kafka构建实时分析Dashboard案例——步骤四:结果展示》

开发团队:厦门大学数据库实验室 联系人:林子雨老师ziyulin@xmu.edu.cn

版权声明:版权归厦门大学数据库实验室所有,请勿用于商业用途;未经授权,其他网站请勿转载

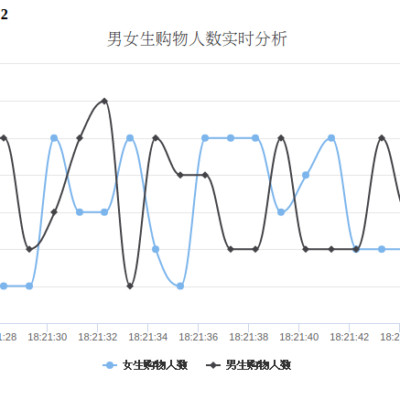

本教程介绍大数据课程实验案例“Spark+Kafka构建实时分析Dashboard”的第四个步骤,结果展示。在本篇博客中,将介绍如何利用Flask-SocketIO向客户端发送消息以及客户端如何利用highcharts.js展示数据。

Spark+Kafka构建实时分析Dashboard案例——步骤三:Spark Streaming实时处理数据

查看前一步骤操作步骤二:数据处理和Python操作Kafka

《Spark+Kafka构建实时分析Dashboard案例——步骤三:Spark Streaming实时处理数据》

开发团队:厦门大学数据库实验室 联系人:林子雨老师ziyulin@xmu.edu.cn

版权声明:版权归厦门大学数据库实验室所有,请勿用于商业用途;未经授权,其他网站请勿转载

本教程介绍大数据课程实验案例“Spark+Kafka构建实时分析Dashboard”的第三个步骤,Spark Streaming实时处理数据。在本篇博客中,将介绍如何利用Spark Streaming实时接收处理Kafka数据以及将处理后的结果发给的Kafka。