作者:厦门大学信息学院计算机科学系2023级研究生 黄万嘉

指导老师:厦门大学数据库实验室 林子雨 博士/副教授

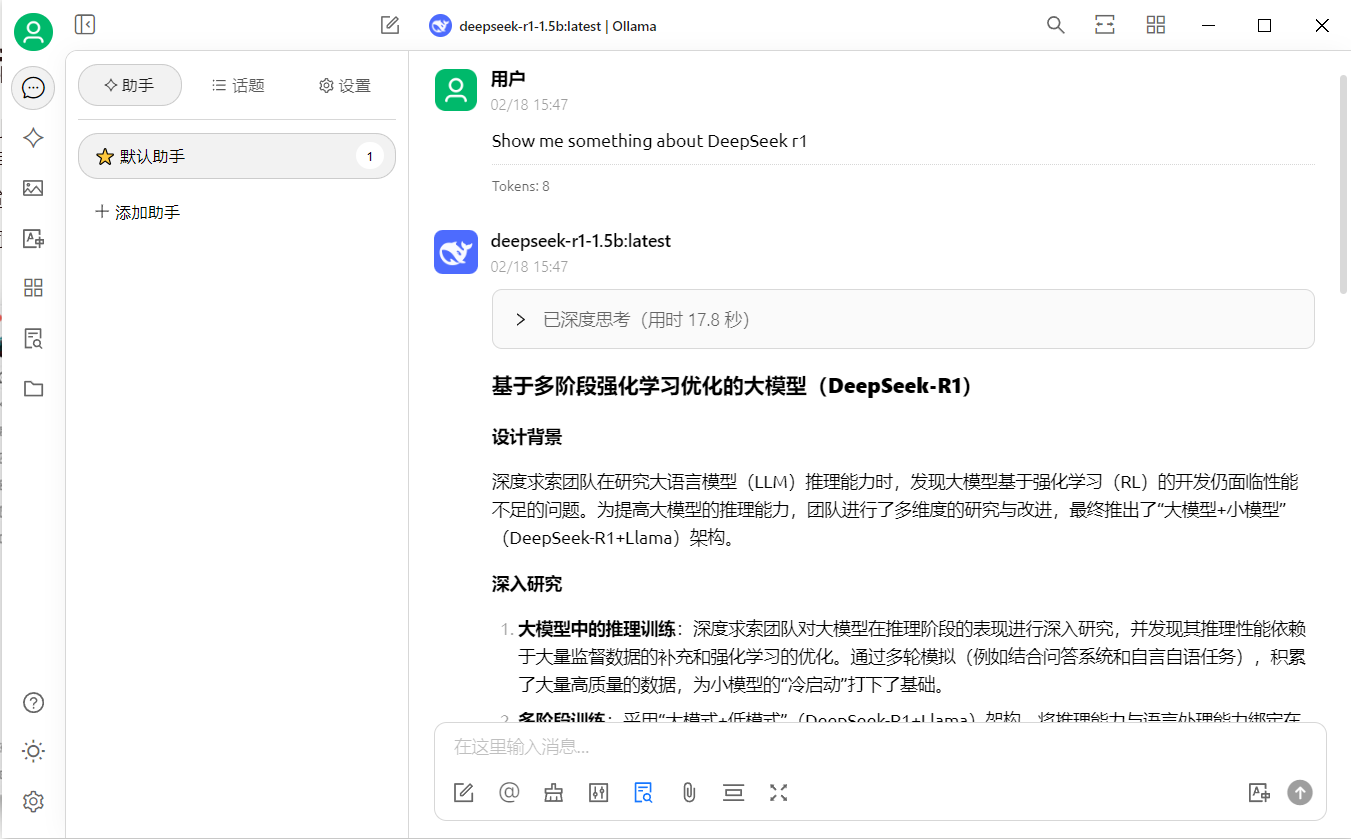

Cherry Studio 是一款功能强大的跨平台桌面客户端,专为支持多模型服务而设计,旨在为用户提供高效、便捷的 AI 交互体验。它集成了超过 300 个大语言模型,支持多种主流 AI 服务商(如DeepSeek ),并兼容本地模型运行(通过 Ollama),满足用户在不同场景下的需求。

本文使用到的工具及模型有:

- Ollama:模型部署工具

- DeepSeek R1 1.5b:推理模型,基于Ollama本地部署

- nomic-embed-text:嵌入模型,用于对输入的文件(知识)进行向量化

- Cherry Studio:集成各功能的AI助手平台

通过上述工具和模型,可以构建一个本地的知识库,帮助大模型进行更准确地回复。

安装Cherry Studio

直接访问Cherry Studio官网进行下载:https://cherry-ai.com/

Cherry Studio中知识库功能原理

知识库的用处

知识库是 Cherry Studio 的核心功能之一,它通过结合外部知识库与大语言模型的能力,显著提升了模型的回答质量和实用性。构建本地知识库可以帮助我们更好地使用大模型,他可以做到:

提升回答准确性

- 通过检索外部知识库,减少模型“幻觉”,生成更可靠的答案。

- 特别适合需要精确信息的场景,如法律、医疗、金融等领域。

支持实时更新

用户可以随时上传最新数据,确保模型回答基于最新信息。

多源数据整合

支持文件(PDF、DOCX 等)、文件夹、网页链接、纯文本等多种数据来源。

高效检索与问答

基于语义的向量检索,快速找到相关文档片段,提升工作效率。

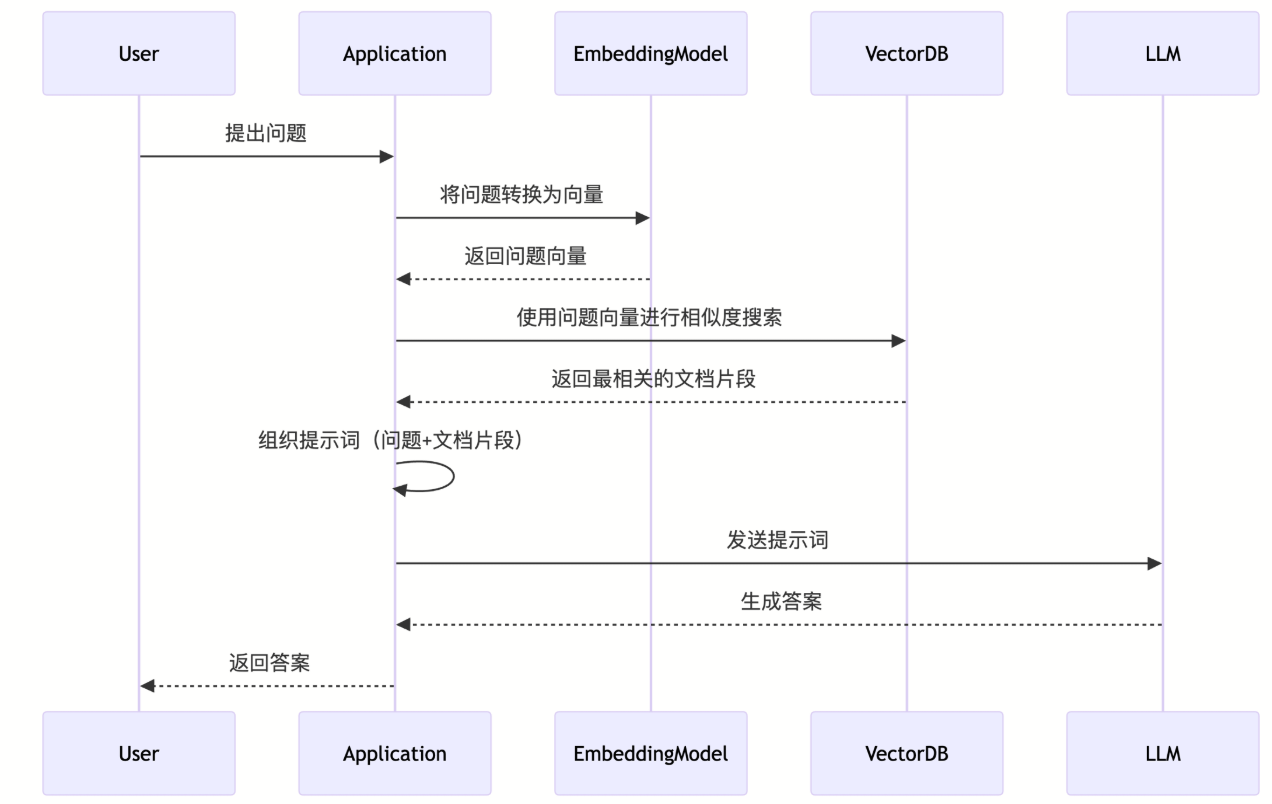

知识库原理

在 Cherry Studio 知识库中添加的数据全部存储在本地,在添加过程中会复制一份文档放在 Cherry Studio 数据存储目录,当文档被添加到 Cherry Studio 知识库之后,文件会被切分为若干个片段,然后这些片段会交给嵌入模型进行处理,当使用大模型进行问答的时候,会查询和问题相关的文本片段一并交个大语言模型处理。

在本文中,我们选择“nomic-embed-text”作为EmbeddingModel,DeepSeek-r1-1.5b作为LLM

在Cherry Studio中使用知识库

模型安装

在正式使用知识库之前,需要先安装nomic-embed-text模型和DeepSeek R1 1.5b模型,关于这两者的安装,可以直接通过Ollama进行安装,详细的细节可以参考:

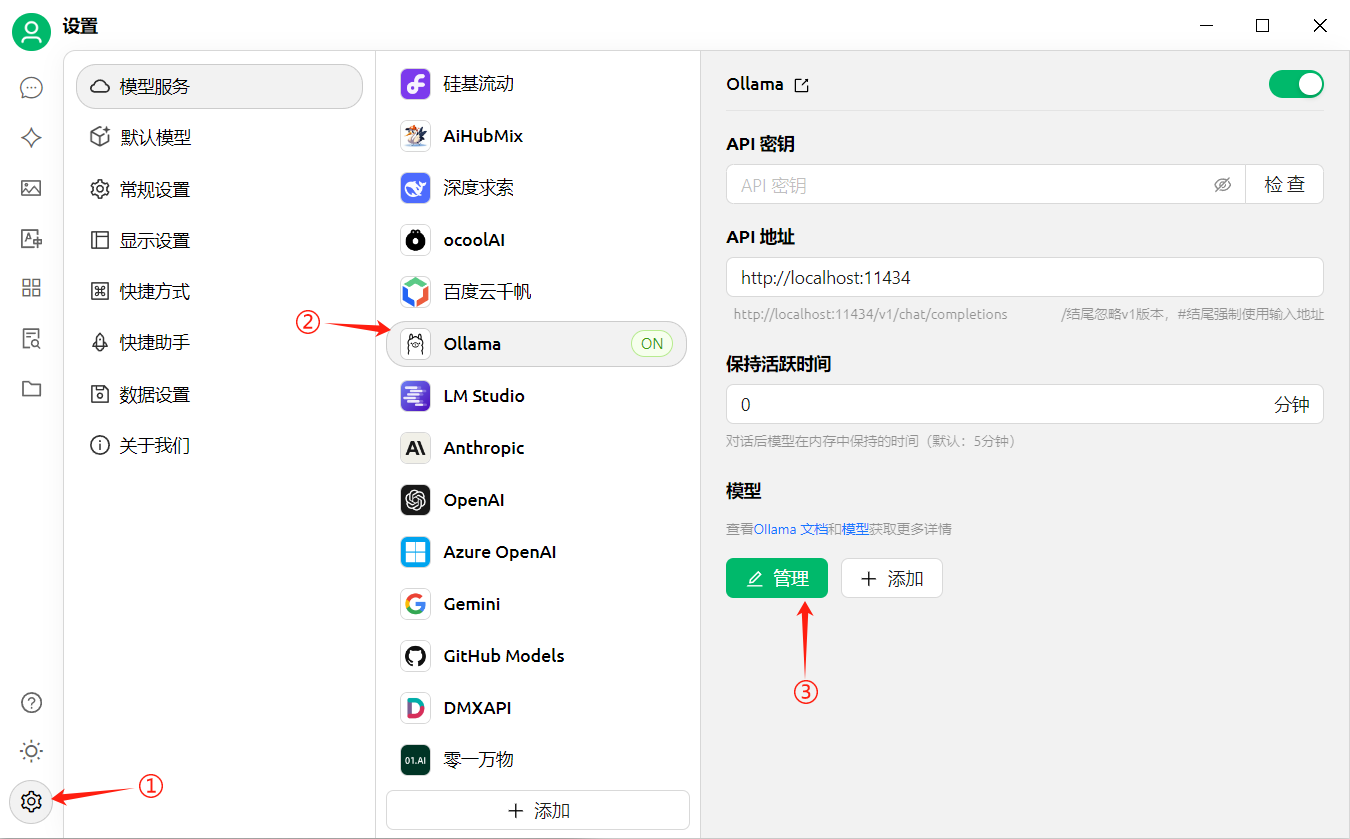

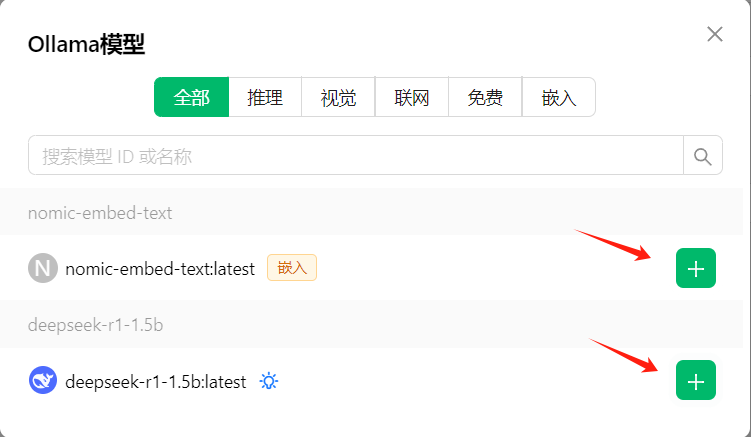

设置嵌入模型和推理模型

- 在模型管理服务中找到Ollama,点击管理

- 找到需要的nomic-embed-text和DeepSeek R1 1.5b,添加到我的模型。

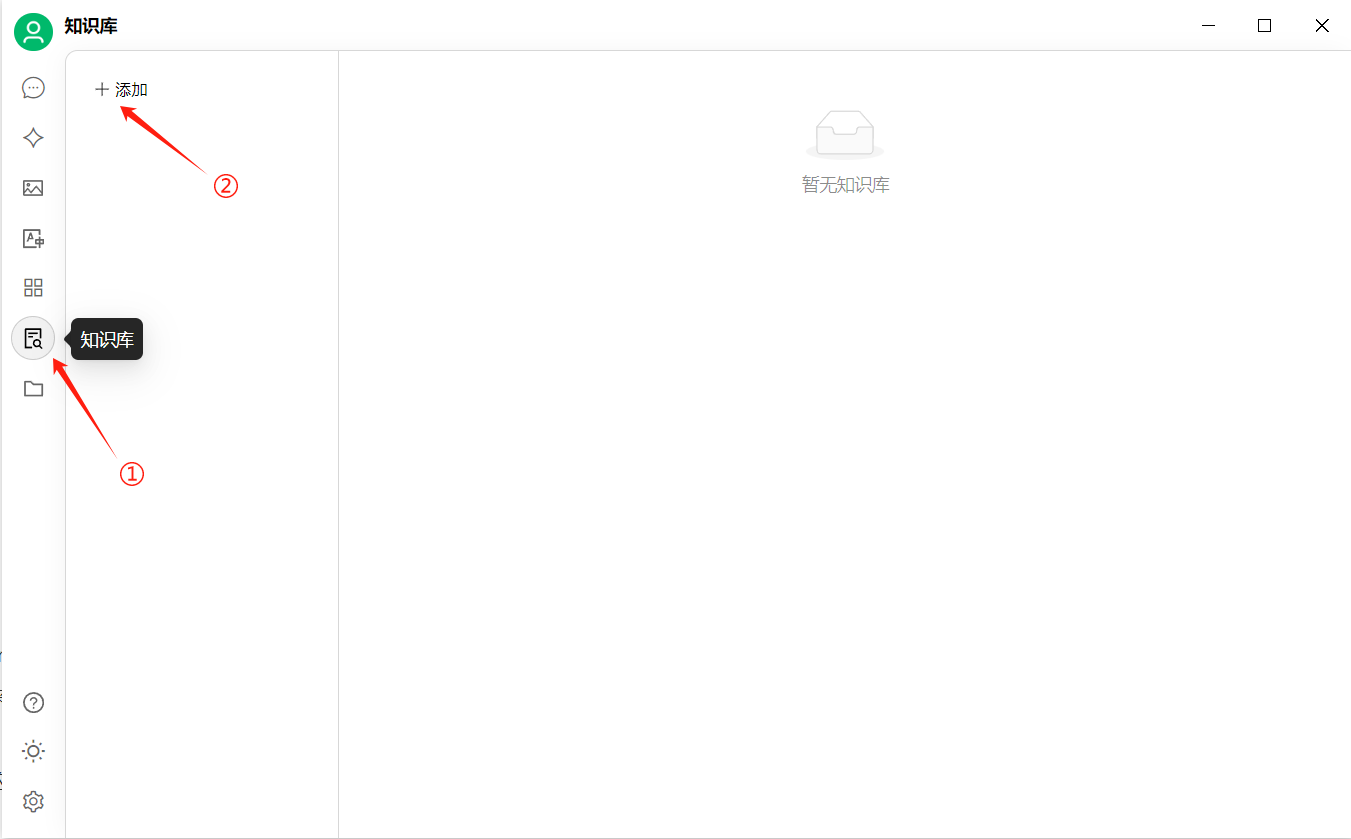

创建知识库

- 知识库入口:在 CherryStudio 左侧工具栏,点击知识库图标,即可进入管理页面;

- 添加知识库:点击添加,开始创建知识库;

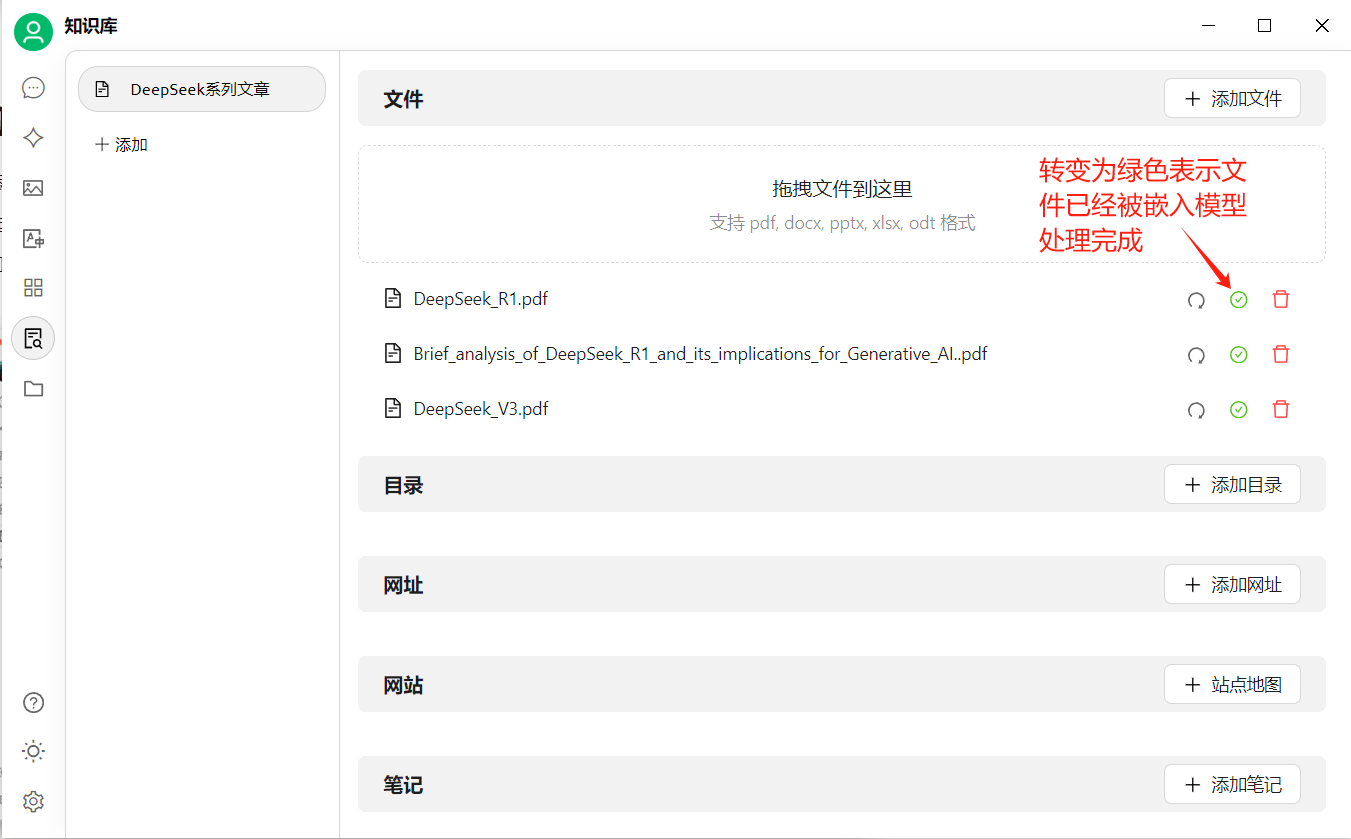

- 命名:输入知识库的名称并添加嵌入模型,以 nomic-embed-text为例,创建一个DeepSeek系列文章知识库。

创建成功后可以添加文件进入知识库,进行向量化操作

- 添加文件:点击添加文件的按钮,打开文件选择;

- 选择文件:选择支持的文件格式,如 pdf,docx,pptx,xlsx,txt,md,mdx 等,并打开;

- 向量化:系统会自动进行向量化处理,当显示完成时(绿色 ✓),代表向量化已完成。

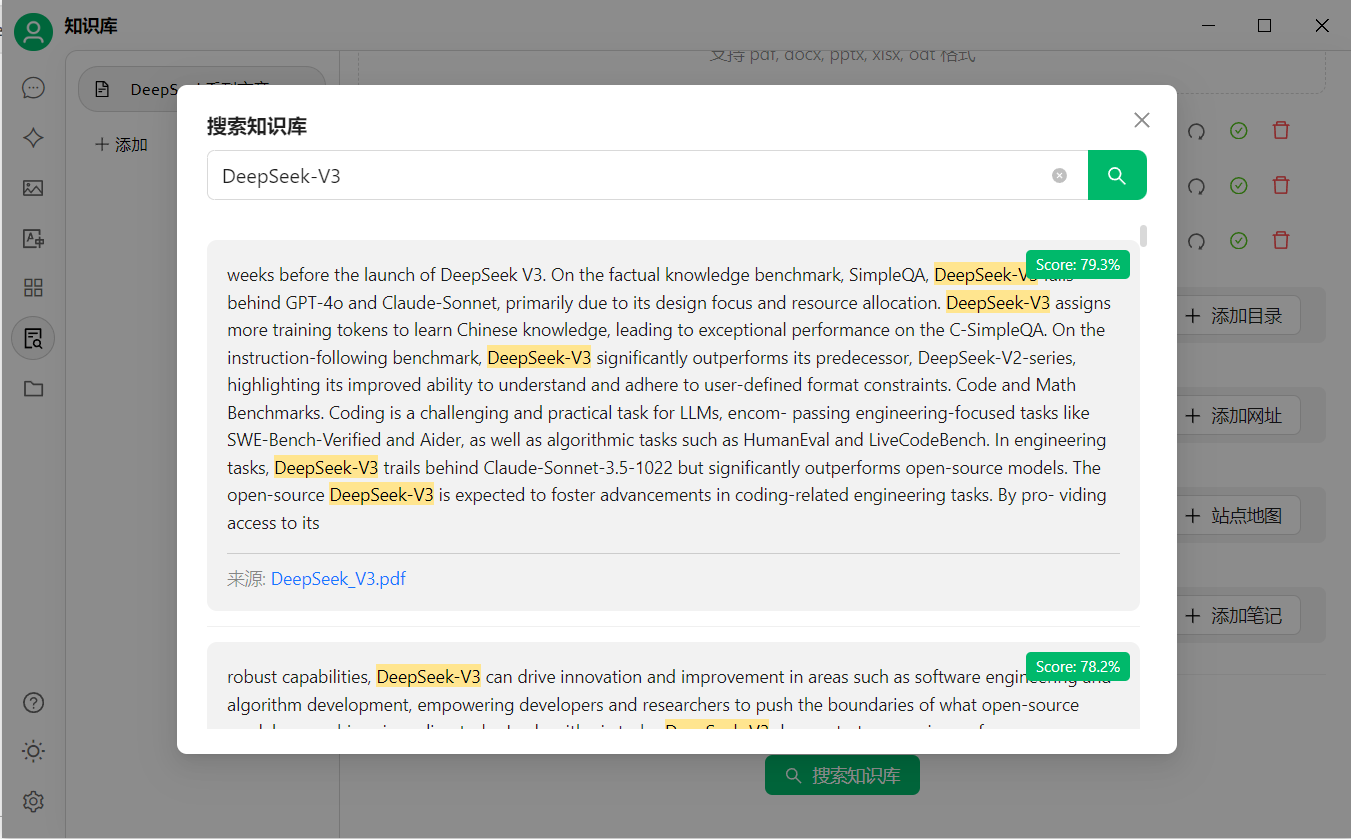

向量化完成后,可以搜索数据库,并显示该条结果的匹配分数。

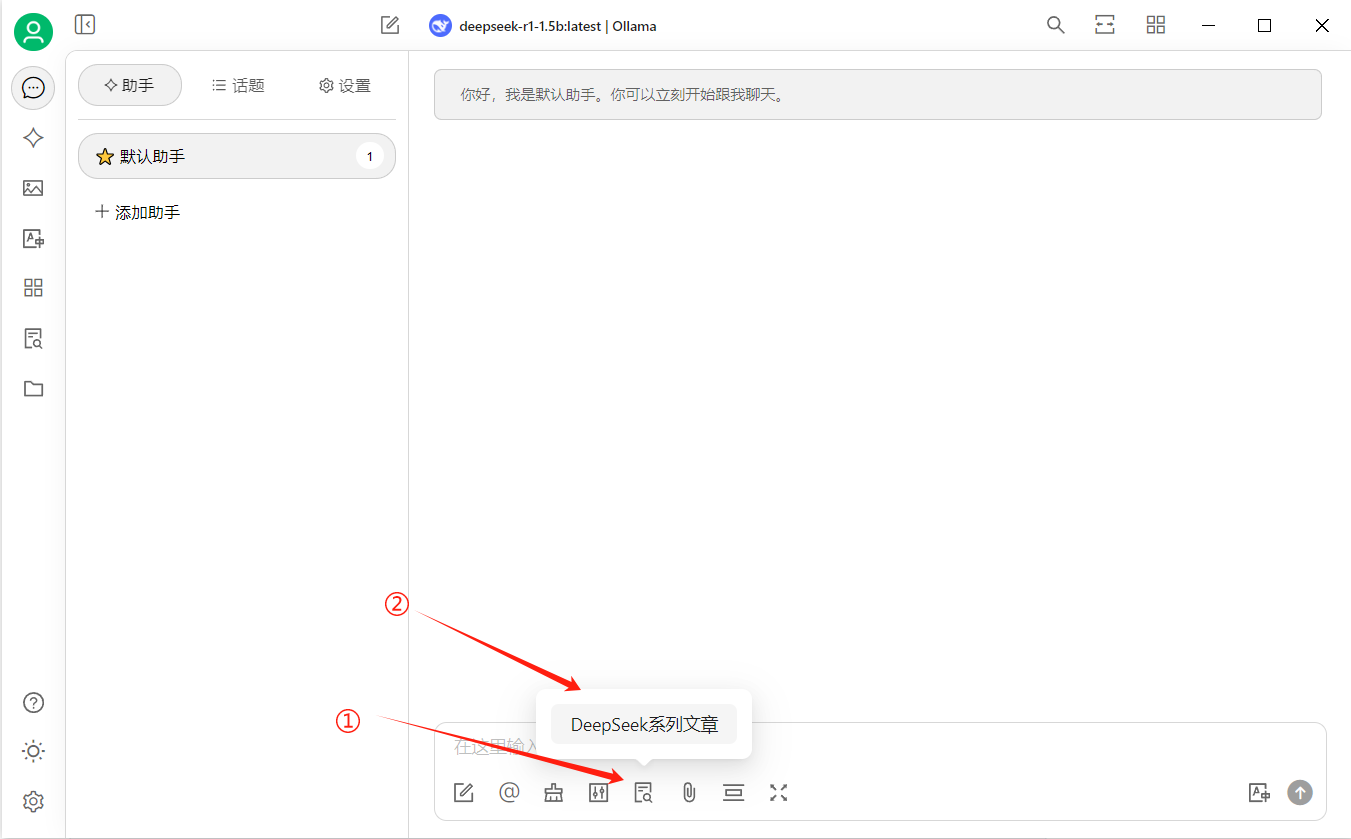

使用知识库问答

- 创建一个新的话题,在对话工具栏中,点击知识库,会展开已经创建的知识库列表,选择需要引用的知识库;

- 输入并发送问题,模型即返回通过检索结果生成的答案 ;